2024.07.09

クラウドからローカルへ、そして近い将来にはハイブリッドへと変わっていくAI演算の処理

フリーランスライター:笠原 一輝

AI PCが大きな話題を呼んでいるが、そのAI PCの肝となるのは、AI推論処理がクラウドでの処理からエッジ側での処理になるという部分で、演算処理がインターネット側(クラウド)なのか、デバイス上(エッジ)なのか、どこで行なわれるかが大きな違いとなっている。

このクラウドからエッジへというトレンドはどうして発生したのだろうか?そもそも演算の主体がクラウドになっていたのはどういう背景があってそうなっていたのかなどに関して、ITの歴史を振り返りながら紹介していきたい。

そうした歴史を振り返っていくと、AIの推論処理をエッジで行なうAI PCのメリットが浮き彫りになってくる。

ITのアーキテクチャはクラウドとエッジを行ったり来たり、振り子のように振れてきたのが歴史

「ITのアーキテクチャはクラウドとエッジの行ったり来たりを繰り返している」…というのは、別にITの偉い人の名言でも何でもない。ITに関係している関係者なら誰もが等しく得る感想だ。

クリックして拡大表示

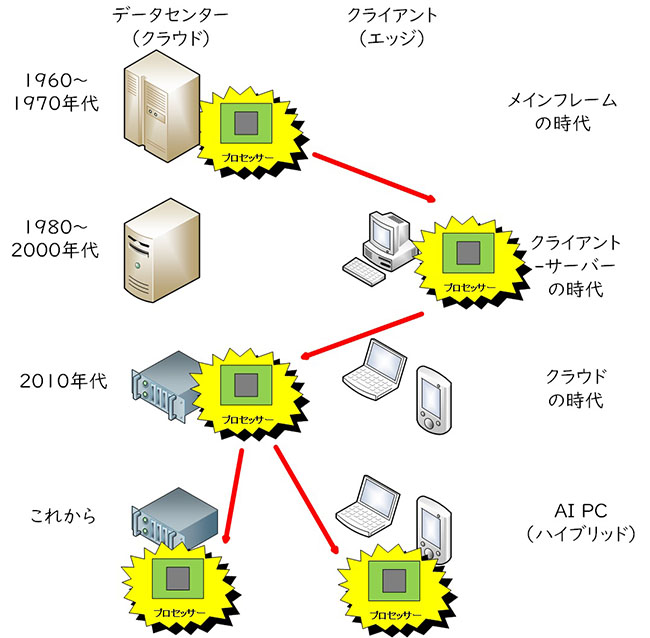

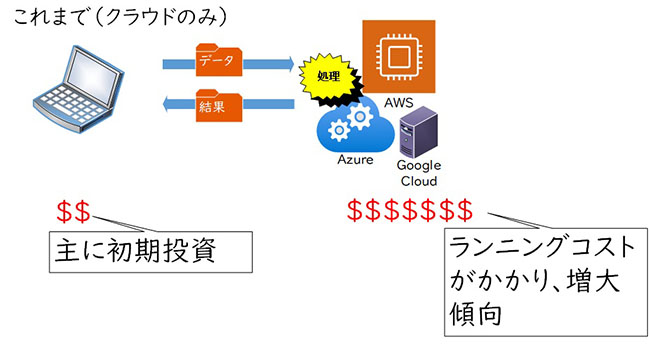

図1:ITでデータの処理が行なわれる場所(概念図、筆者作成)

ITの歴史を振り返ると、1950年代~1960年代にはコンピューターのアーキテクチャは「メインフレーム」と呼ばれる。今で言うデータセンターに巨大なコンピューターが鎮座しており、それを利用してさまざまな処理を行なうという仕組みになっていた。というのも、当時は半導体やコンピューターの技術そのものが未熟で、処理能力が圧倒的に低かったため、十分な処理能力を実現するには大規模にするしかなかったからだ。

それが1970年代~1980年代には、半導体の技術が長足の進歩を遂げたこともあり、今で言うデスクトップPCのサイズで(メインフレームなどに比べると)圧倒的に小型のパーソナルコンピューター(PC)の時代が到来した。メインフレームからPCへとダウンサイジングが実現したのだ。

さらに1980年代~2000年代の前半に向けては、インターネットのようなネットワーク技術も進化。それにより、データセンターの中にデータを集中的に保存しておくサーバーと呼ばれるコンピューターを置き、ユーザー個々人が持つクライアントと呼ばれるPCからアクセスするという「クライアント-サーバー」と呼ばれる形のITが一般的になる。データの置き場所としてサーバーを活用し、データの処理はクライアントで行なうという形が一般的だった。

2010年代に入ると、「クラウドコンピューティング」と呼ばれる時代に入る。クラウドコンピューティングの時代では、仮想化技術を活用することでクライアントーサーバーのアーキテクチャがさらに発展して、コンピューティングリソース(CPUやGPUなどのデータを処理するプロセッサーのこと)もデータセンターに格納して、クライアントからネットワーク経由で利用できるようになっている。 また、00年代後半からはスマートフォンのように、PCに比べるとCPUやGPUなどの処理能力が非力なデバイスが主流になってきたこともあり、Webアプリケーションと呼ばれるような、データの処理はクラウド側で行ない、その結果をクライアントに返す形のアプリケーションが増えてきた。

そうしたアプリケーションの代表例としては、現在話題の対話型生成AIとなるOpenAIのChatGPT、MicrosoftのCopilot、GoogleのGeminiなどがあげられるが、(現時点では)これらの生成AIはクラウド側で処理を行ない、結果をデバイス側に返す形になっている。

このように、ITのシステムというのはメインフレーム、ダウンサイズされたパーソナルコンピューター、クライアント-サーバー、クラウドコンピューティングのように段階的に発展してきて、データを処理する場所も振り子のようにデータセンター、クライアント、データセンター、クライアントと振れてきた。それが歴史となる。

クラウドコンピューティングの三つの課題、それはクラウド型のAIでも大きな課題に

クリックして拡大表示

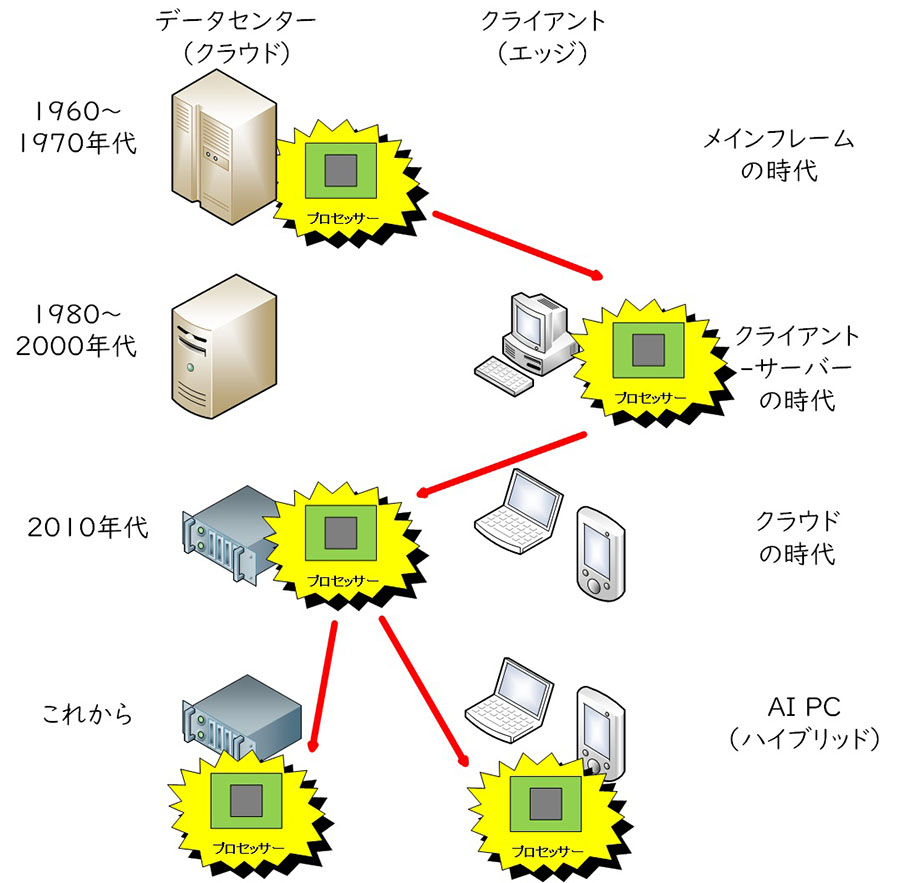

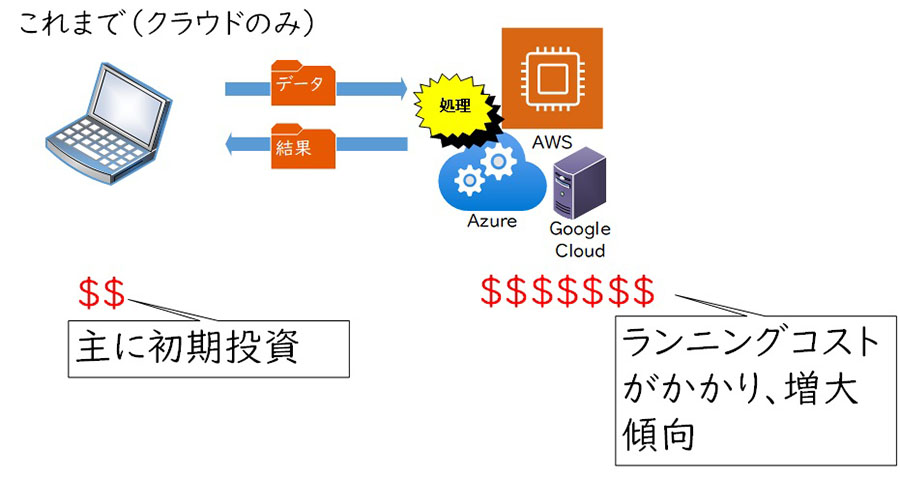

図2:クラウドコンピューティングでのAI処理(概念図、筆者作成)

そうしたクラウドコンピューティングだが、普及が始まって15年近くが経過して、いくつかの課題が見えてきている。クラウドコンピューティングが抱える課題は大きくいって三つある。それがレイテンシー(遅延)、セキュリティ、そして最後にコストだ。

レイテンシーとは、ある処理を命じてからその処理が終わるまでの時間のこと。例えば、ユーザーがPCにこういう作業をしてほしいとオーダーを出してからその結果が帰ってくるまでの時間と考えるとわかりやすい。

言うまでもなくレイテンシーは短ければ短いほど、ユーザー体験が優れているということができる。クラウドのWebアプリケーション、先ほど例に出したChatGPTなどでは、ユーザーがプロンプトと呼ばれるテキストボックスに指令をいれて、その指令がサーバー側で処理されて、ユーザーが使っているPCなどに返ってきて結果として表示されるまでに、ある程度の時間が必要になる。それがレイテンシーということになる。

現在のクラウドベースの生成AIではこのレイテンシーの長短はネットワークの帯域とデータセンターの位置に依存する。ネットワークの帯域が十分でなければデータ(例えば写真や動画)をアップロードするのに時間がかかる。また、データセンターがユーザーのいる地域から遠く(例えば日本のユーザーが米国のデータセンターに接続する場合)などにも、途中複雑なインターネットの経路を通過することになるため、時間がかかることになる。それによりレイテンシーは長くなり、その間数秒から数十秒またされることになるので、ユーザーはイライラすることになる。

イライラするぐらいならいいが、アプリケーションの種類によってはレイテンシーが大きいとそもそもアプリケーションとして成立しなくなる。例えば、同時通訳のアプリケーションをAIで実現する場合を考えてほしい。話すたびに数秒のレイテンシーがあれば、どんどん遅れていって、「同時」ではなくなってしまうことは容易に想像できるだろう。

セキュリティの問題は、データの管理権の問題だ。クラウド型のAIアプリケーションは、利用時にユーザーがデータを何らかの形でアップロードするか、データを常時クラウドストレージに置いておく必要がある。きちんと利用規約が取り決められているビジネス向けのデータストレージはともかくとして、一般消費者向けの対話型AIでは、クラウドにアップロードした後のデータの取り扱いなどがきちんとユーザーに通知されていなかったり、あるいは通知されていてもユーザーがきちんと読んでいなかったりと、そのデータの管理には課題が残っている。

例えば、そのアップロードされたデータが、その後AIの学習に使われるとサービスの規約に書いてあり、同意のボタンを押しているのに、ユーザーがそのことを認識していない場合などがそれに該当する。MicrosoftとLinkedInが最近発表した調査では、AIを利用したことがある企業の従業員のうち78%がBYOAI(Build Your Own AI、企業が契約していないAIサービスを業務に利用すること)の経験があると答えているという結果もあり、企業のIT管理上課題があることは否定できないだろう。

最後にコストの問題がある。クライアント-サーバーの時代には、企業ITの初期投資はサーバーとPC、それにそれぞれにかかるソフトウエアのコストがメインだった。しかし、クラウド時代には様相は大きく異なっている。クラウドはサービスやハードウエアを使った時間だけ支払うという形や、月額や年額といったサブスクリプション型の課金モデルが一般的だ。このため、初期投資は圧倒的に低く抑えられるが、システムが大規模になると支払いがかさむというのが一般的だ。仮にAIのアプリケーションをクラウドで構築すると、毎月それを運用するコストがかさんでいくことになる。それを払いきれる大企業であればよいが、中小企業にとって負担は小さく無いと言える。

このような課題を抱える、クラウド型のAIに対する歴史の必然として登場したのが、AI PCあるいはオンデバイスAI(スマートフォンの場合はこう呼ばれる事が多いが、本質的には同じ仕組みなのでAI PCで統一する)のような、ローカルのプロセッサーでAIの処理を行なうタイプのデバイスなのだ。

クラウドからローカルへ、そして将来はハイブリッドへと移り変わっていくAI処理の場所

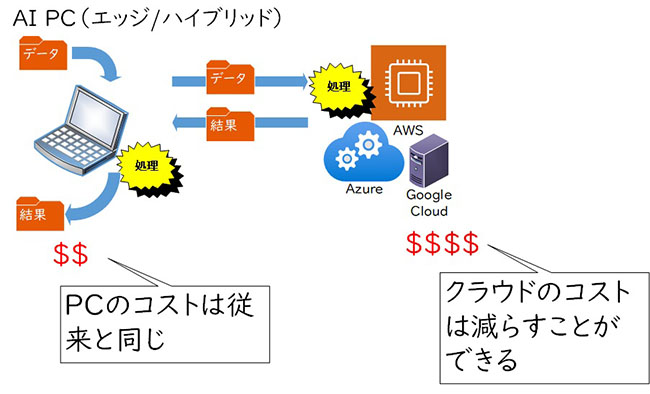

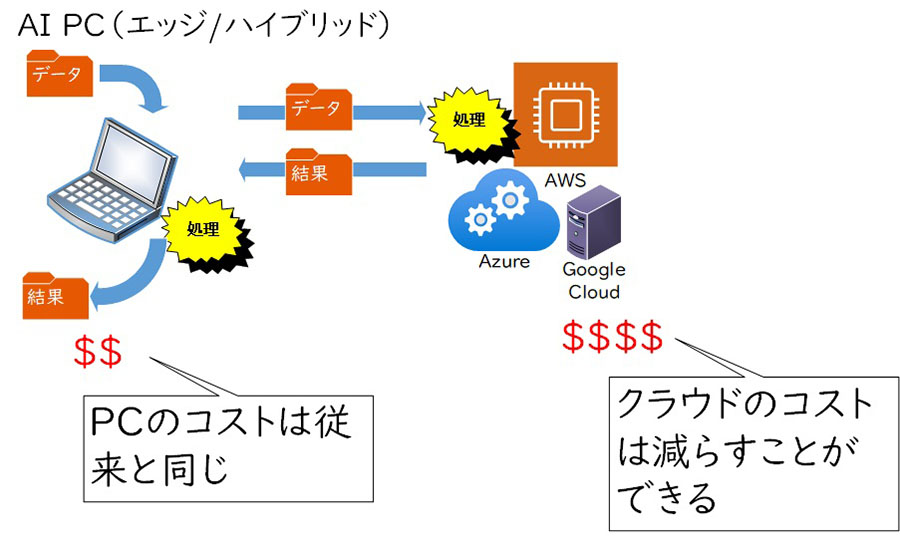

クリックして拡大表示

図3:AI PCでのAI処理、クラウドからローカル・ハイブリッドへ(概念図、筆者作成)

AI PCでは、ローカルのプロセッサー(SoCに内蔵されている、CPU/GPU/NPUのうち一つないしは複数)を利用してAI処理を行なう。すべての処理はローカルで行なわれるため、先ほど指摘したクラウド型のAIアプリケーションが抱えるレイテンシー、セキュリティ上の懸念、そしてコストという問題のすべてが解決されている。

クラウド型AIでレイテンシーが発生する要因はネットワークの帯域とデータセンターとの地理的な距離であることは説明した通りだが、AI PCの場合にはPCの中にあるプロセッサーで処理を行なうため、データが外に出て行くことはない。このため、ネットワークが要因のレイテンシーは発生しようがない。もちろん、プロセッサーがデータの読み込み処理を終えてディスプレーに表示するまでのレイテンシーは存在するが、せいぜいミリ秒単位のレイテンシーで、数秒から数分の単位で発生するネットワークのレイテンシーに比べれば無視できる範囲だ。

また、データがネットワークを経由してデバイスの外には出て行かないため、セキュリティの懸念も存在しない。BYOAIのように、企業が契約していないAIアプリケーションを従業員が利用したとしても、データはローカルにとどまっているため、クラウド型のAIをBYOAIで使う場合に比べると、データ漏えいの危険性は圧倒的に低い。

そして最後にコストだ。AI PCでは、AI PCを購入する時、ソフトウエアの導入時にコストが発生するが、逆に言うとコストはその初期投資だけで済むことになる。クラウドを利用する場合では毎月定額のコストないしは使った時間分だけコストが発生するのに比べると、コストの計算がしやすく、初期投資だけで済むことはAI PCのメリットと言える。

もちろん、全てのAIアプリケーションがローカル実行になるなどということはあり得ない。クラウド実行とローカル実行が混在するような「ハイブリッド」へ移行するというのが現実的な解になるだろう。今後は徐々にそうしたアプリケーションが増えていく可能性があり、AI PCはそうした時代への入り口を示しているということができるだろう。

HPは、ビジネスに Windows 11 Pro をお勧めします。

Windows 11 は、AIを活用するための理想的なプラットフォームを提供し、作業の迅速化や創造性の向上をサポートします。ユーザーは、 Windows 11 のCopilotや様々な機能を活用することで、アプリケーションやドキュメントを横断してワークフローを効率化し、生産性を高めることができます。

組織において Windows 11 を導入することで、セキュリティが強化され、生産性とコラボレーションが向上し、より直感的でパーソナライズされた体験が可能になります。セキュリティインシデントの削減、ワークフローとコラボレーションの加速、セキュリティチームとITチームの生産性向上などが期待できる Windows 11 へのアップグレードは、長期的に経済的な選択です。旧 Windows OSをご利用の場合は、AIの力を活用しビジネスをさらに前進させるために、Windows 11 の導入をご検討ください。

※このコンテンツには日本HPの公式見解を示さないものが一部含まれます。また、日本HPのサポート範囲に含まれない内容や、日本HPが推奨する使い方ではないケースが含まれている可能性があります。また、コンテンツ中の固有名詞は、一般に各社の商標または登録商標ですが、必ずしも「™」や「®」といった商標表示が付記されていません。

※2024年7月9日時点の情報です。内容は変更となる場合があります。

ハイブリッドワークに最適化された、

Windows 11 Pro+HP ビジネスPC

ハイブリッドなワークプレイス向けに設計された Windows 11 Pro は、さらに効率的、シームレス、安全に働くために必要なビジネス機能と管理機能を搭載しております。HPのビジネスPCに搭載しているHP独自機能はWindows 11で強化された機能を補完し、利便性と生産性を高めます。