生成AIのリスク完全ガイド:今日から実装する安全対策

2026-01-13

ライター:倉光哲弘

編集:小澤健祐

なぜ今、生成AIのリスク管理がビジネスに不可欠なのか?

生成AIの本格導入を進める上で、「何が法的なリスクなのか」「どうすれば安全に使えるのか」といった悩みを抱えていませんか。

生成AIは業務効率を飛躍的に向上させる一方、不用意な利用は情報漏洩や著作権侵害といった重大な問題に直結するため、適切なリスク管理が不可欠です。実際に国内外でガイドラインの整備が急速に進んでおり、企業には事業継続のために具体的な対策が求められています。

たとえば、従業員が機密情報を入力したことによる情報漏洩事件や、学習データが原因で大手メディアが訴訟を起こした著作権問題は、決して他人事ではありません。さらに、海外では厳しい罰則を伴う「EU AI Act」のような規制も段階的に適用が始まっています。

本記事では、AI活用に伴うリスクの全体像から具体的な対策までを網羅的に解説します。さらに、国内外の指針に基づいた90日間の導入ロードマップと社内ルールの雛形も提示し、貴社における安全なAI運用体制の構築を具体的に支援します。

経営者が知るべき生成AIリスクの全体像:3つの層と法的・技術的ガイドライン

生成AIのリスクを正しく評価するため、本章では3つの視点から全体像を解説します。国内外のガイドラインや海外の規制動向を押さえた上で、リスクを「利用者」「提供者」「社会」の3層に分類し、経営判断に必要な軸を明確にします。

国内ガイドラインの要点: 総務省・経産省が示す「AI事業者ガイドライン1.0」と、デジタル庁・IPAの最新指針

国内のガイドラインは、生成AIの安全な業務利用に向けた具体的な指針を示しています。これらは、AIの活用を止めずにリスクを管理し、行政と企業が足並みをそろえて安全な普及を目指すために策定されました。

主要な指針として、以下のものが挙げられます。

- 総務省・経済産業省「AI事業者ガイドライン第1.1版」: 2025年3月に更新され、国際的な議論も反映しつつ、開発者から利用者までの各立場で果たすべき責務を定義しています。

- デジタル庁: AIのリスクを4つの軸で評価する基準や、導入推進責任者(CAIO)の設置といった組織体制の指針を示しています。

- IPA(情報処理推進機構): 社内規定を策定する上で参考になる、入力すべきでない情報の具体例や、ログ管理で考慮すべき事項を提示しています。

これらの公的な指針を自社のルールや監査体制の基盤とすることこそ、安全なAI活用を実現する上で、最も確実かつ効率的なアプローチと言えます。

参考:

総務省・経済産業省 (2025) 『AI事業者ガイドライン(第1.1版)』

デジタル庁 (2025) 『先進的AI利活用アドバイザリーボードの設置について』

デジタル庁 (2025) 生成AI利活用における高リスク判定チェックリスト

独立行政法人情報処理推進機構(IPA) (2024) 『テキスト生成AIの導入・運用ガイドライン』

海外フレームワークと時限規制: EU AI ActとNIST AI RMFが示す「リスク基準」と、日本企業への影響

海外、特にEUのAI規制は、グローバルに事業を展開する日本企業にとって無視できない設計条件となっています。これらの規制は、違反した場合に巨額の罰金が科されるだけでなく、取引先からの信頼性評価にも直結するため、早期の対応が不可欠です。

代表的な2つの枠組みには、それぞれ異なる役割があります。

- EU AI Act(EU AI法): AIをリスクレベルで分類し、禁止事項や高リスクAIへの義務を定める法律です。2025年から段階的に適用が始まっており、日本企業も対象となる場合があります。

- NIST AI RMF: AIのリスクを「統治・特定・測定・管理」するための具体的な運用手順を示した、実践的な手引書(フレームワーク)です。

法的な義務である「EU AI法」への準拠に向け、その達成プロセスとして「NIST AI RMF」を活用し社内体制を整備することが、最も現実的かつ効果的な対策です。

参考:

欧州連合 (EU) 『EU AI法 (EU Artificial Intelligence Act)』

米国国立標準技術研究所 (NIST) 『AI リスクマネジメントフレームワーク (AI RMF 1.0)』

PwC Japanグループ 『生成AIを巡る米欧中の規制動向最前線 NIST「AIリスクマネジメントフレームワーク(AI RMF)」の解説』

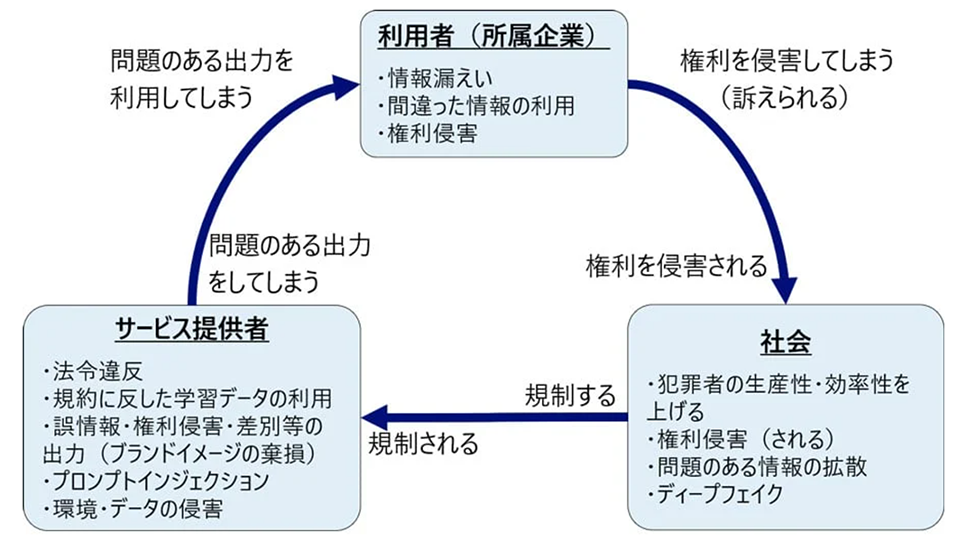

リスクの3層構造: 「利用者」「提供者」「社会」それぞれの視点で発生する問題とは?

生成AIのリスクは、単一の問題ではなく「利用者」「提供者」「社会」という3つの異なる階層で捉えることが重要です。なぜなら、それぞれの立場でリスクの原因と影響が異なり、必要な対策も変わってくるためです。

具体的なリスクとして、以下のような例が挙げられます。

- 利用者のリスク:従業員が機密情報を入力してしまうことによる、情報漏洩の問題。(例:サムスン電子の事例)

- 提供者のリスク:外部からの攻撃で意図しない動作をさせられる技術的な脆弱性の問題。(例:OWASP LLM Top 10)

- 社会のリスク:AIの生成物を巡る著作権侵害や、偽情報の拡散といった問題。(例:ニューヨーク・タイムズ対OpenAI訴訟)

したがって、「利用者」には教育を、「提供者」には技術を、「社会」には法務を、というように各階層のリスクに最適化した対策を、一体で進めるアプローチが不可欠です。

参考:

NRIセキュアテクノロジーズ株式会社 『生成AIのリスクを整理する|3つの観点でリスクと対策を解説』

Forbes JAPAN 『サムスン、ChatGPTの社内使用禁止 機密コードの流出受け』

OWASP Foundation 『OWASP Top 10 for Large Language Model Applications』

BBC 『マイクロソフトとオープンAIに対する著作権侵害訴訟』

中小企業が直面する3つの主要リスク:情報漏洩、品質問題、そして風評被害

生成AIのリスク対策は、今や企業の必須課題です。情報漏洩や著作権侵害などの問題が、Samsung社の情報漏洩事例のように現実化しているためです。本記事では、企業が直面するリスクの全体像を整理し、明日から実践できる具体的な対策を分かりやすく解説します。

【1】情報保護と知的財産のリスク: 機密情報漏洩と著作権侵害の具体的事例

生成AIへの安易な情報入力や出力結果の利用は、企業の信頼を揺るがす情報漏洩と著作権侵害に直結します。AIが入力データを学習データとして利用する仕組みや、既存のコンテンツと酷似した内容を生成する可能性があるためです。

前の章でも触れた以下の事例は、このリスクが現実化した典型例です。

- 情報漏洩(Samsung社の事例)

従業員が機密情報を含むソースコードをAIに入力した結果、その内容が外部に流出したと報じられました。一度入力した情報は、意図せず学習され、第三者への回答に含まれる危険性を示唆しています。 - 著作権侵害(The New York Times社の訴訟)

自社の記事が許諾なくAIの学習データに利用され、著作権を侵害されたとして、巨額の損害賠償を求めている係争です。生成物が既存の著作物と酷似するリスクを浮き彫りにしました。

これらのリスク防止に、単一の対策は不十分です。データの「入口」(入力ルール化)、「過程」(ログ監査)、「出口」(生成物の確認)というプロセス全体を網羅した、多層的な防御体制の構築が不可欠です。

参考:

日経クロステック 『10万件のChatGPTアカウントが闇市場に、どう盗んだのか誰が欲しがるのか』

日本HP 『アプリケーション 隔離と封じ込めによるプロテクション・ファースト』

NRIセキュア 『生成AIシステムのセキュリティを徹底解説』

【2】品質と技術的脆弱性のリスク: 誤情報(ハルシネーション)、偏見(バイアス)、乗っ取り(プロンプトインジェクション)等

生成AIが出力する事実と異なる情報(ハルシネーション)や、外部からの乗っ取り攻撃(プロンプトインジェクション)は、業務の品質とセキュリティを脅かす重大なリスクです。AIは確率に基づいて回答を生成するため、これらの問題を完全に防ぐことは、国の報告書でも指摘されるほど困難とされています。

具体的には、以下のような品質・脆弱性の問題が指摘されています。

- 品質のリスク

○ ハルシネーション:事実に基づかない、もっともらしい嘘の情報を出力する。

○ バイアス:学習データに含まれる偏見を助長・再生産してしまう。 - 脆弱性のリスク

○ プロンプトインジェクション:不正な指示を埋め込み、開発者の意図しない動作をさせる攻撃。

○ データポイズニング:AIの学習データを汚染し、モデルの判断を誤らせる攻撃。

これらのリスクを実務レベルで低減するには、「人による確認」「技術的な監視」「厳格な権限管理」という3つの観点を組み合わせた対策の標準化が不可欠です。

参考:

三井物産セキュアディレクション株式会社『AIシステムに対する脅威の事例』

株式会社NTTデータ『生成AI導入に向けた課題とリスク』

総務省『令和6年版 情報通信白書』「生成AIが抱える課題」

【3】社会・ブランドイメージのリスク: 意図しない炎上や偽情報拡散、ディープフェイクによる詐欺の危険性

生成AIによる偽情報やディープフェイクの拡散は、一度発生すると訂正が困難なため、企業のブランド価値に「不可逆的」な損害を与える経営リスクに直結します。情報の拡散速度が極めて速いことに加え、EUのAI法では最高3,500万ユーロ(または全世界売上高の7%)という高額な制裁金が科されるなど、法規制も厳格化しているためです。

実際に、企業の存続を脅かす以下のような事例が発生しています。

- 金融詐欺:ビデオ会議で役員になりすますディープフェイク技術により、香港の企業が約38億円を騙し取られた事件

- 市場への影響:大手通信社のSNSアカウントから発信された偽情報一つで、市場価値がわずか数分で一時的に1,360億ドル(約20兆円)も消失した事例

これらのリスクから企業を守るには、「技術」的な対策に加え、「運用」として生成物の明示やレビュー体制を、「組織」として緊急時対応計画を事前に整備するなど、多角的なアプローチが不可欠です。

参考:

日経クロステック(xTECH)『偽プレス・リリースで株価暴落:躍らされた報道機関の責任重大』

世界経済フォーラム 『企業における、偽情報の真のコストとは』

トレンドマイクロ CFO(最高財務責任者)になりすまして2500万米ドルを送金させたディープフェイク技術 』

事例から学ぶ!情報漏洩を防ぐ「ヒト・ルール・技術」の多層防御策

本節では、情報漏洩を防ぐ多層防御を実務に導入するため、社内規定や従業員教育、DLP、ブラウザ隔離(HP Wolf Security)、ゼロトラストまで、現場で使える実装パターンを具体例と共に解説します。

【ルール】 いますぐ作れる社内ポリシーの雛形:禁止事項、利用範囲、検証・承認フロー

現場ですぐに使える社内AIポリシーの雛形を解説します。この雛形はJDLA(日本ディープラーニング協会)の5章構成を拠り所としているため、網羅的で信頼性が高いです。

たとえば、以下のような具体的なルールを定義します。

- 禁止入力: 個人情報は原則禁止とし、例外は部長承認とログ化を必須とする

- 利用範囲: 著作権に配慮し、承認のない業務利用を禁止する

- 成果物: 外部公開文書は2名で検証し、責任者が承認する

- 記録: プロンプト・出力・承認者を90日間保存する

これらの規定はNIST AI RMFなどにも対応しており、現場の迷いを減らして監査に強い運用を実現します。

参考:

資料室 - 一般社団法人日本ディープラーニング協会【公式】

【ヒト】 従業員のAI活用リテラシーを高める教育・周知のポイント

ポリシーの策定だけではAIリスクを防げず、従業員一人ひとりが防波堤となる「ヒューマンファイアウォール」の構築が不可欠です。日常業務における些細な誤用が、情報漏洩や風評被害といった重大なインシデントに直結するため、体系的な教育が求められます。

そのために、以下の施策を組み合わせます。

- 段階的研修: 3ヶ月かけて経営層から全社員へと展開する

- 必須eラーニング: ハルシネーションや機密情報入力のリスクを30分で疑似体験させる

- 知識の定着: 理解度テストに加え、OWASP LLM Top 10など最新の脅威に関する情報を定期的に更新する

これにより、全社員のセキュリティ意識を底上げし、AIを安全に活用できる組織体制を築けます。

【技術】 ゼロトラスト環境の構築:DLP、監査ログ、そして「HP Sure Click」によるエンドポイントの隔離技術

AIを安全に利用するゼロトラスト環境には、情報漏洩を防ぐ「DLP」、証跡を管理する「監査ログ」、脅威を封じ込める「エンドポイント隔離」が重要な要素です。本章では、これらの具体的な実装方法を解説します。

AI対応DLP:セマンティック検知とリアルタイム制御

AI時代の情報漏洩対策として、文章の意味を理解して検知するDLPが有効です。従来のキーワード一致型では、AIによる巧みな情報の言い換えや要約に対応できないためです。

たとえば、以下のようなAIに特化した制御を行います。

- Copilotの応答生成で感度ラベル付きアイテムの利用を抑止(本文は応答に含めず出典のみ表示可)。

- テキストの機密要素を検出し自動マスキング/置換(DLP APIのredaction機能を活用)。

- 自社エージェントや外部接続をデータポリシーで制御(コネクタ/エンドポイントを許可・禁止)。

これにより、端末やSaaSなど環境を問わず、AI利用における情報漏洩リスクを低減することが期待されます。

参考:

- Microsoft Learn 『Microsoft 365 Copilot のデータ所在地について』

- Google Cloud 『機密データの保護のドキュメント』

- Microsoft Learn 『エージェントのデータポリシーを構成する - Microsoft Copilot Studio』

監査ログとモニタリング:証跡を資産化

万一のインシデントに備え、原因を追跡できる監査ログの整備は不可欠です。実際にサムスン電子の情報漏洩事例では、証跡管理が大きな課題となりました。誰が、いつ、何を入力し、どのような応答を得たかを記録する仕組みがなければ、迅速な対応は困難です。

具体的には、以下の対応を徹底します。

- 統合監査ログにCopilot Interactionメタデータ(ユーザー、AppHost、AccessedResources等)を収集。プロンプト/応答本文は既定で収集しない。

- ログを90日~180日保管。E5やAudit Premiumで1年~10年まで拡張。

- 承認ワークフローと監査イベントIDを突合し、SIEM/SOARでアラート化(運用設計の推奨)。

これにより、単なる記録だったログを、ガバナンス強化とセキュリティ分析に活かす資産へと変えることができます。

参考:

Microsoft Learn 『監査ログのアクティビティ』

Microsoft Learn 『Microsoft Purviewの監査ソリューション』

Microsoft Learn 『Copilot Interaction』

Splunk 『SplunkによるCopilotログのセキュリティ分析入門』

エンドポイント隔離:HP Sure Click

ゼロトラストの最後の砦として、脅威を「検知」するのではなく、実行環境そのものを「隔離」するエンドポイント対策が有効です。生成AIの出力に含まれる未知の不正コードや悪性リンクは、従来の検知型セキュリティをすり抜ける可能性があるためです。また、この隔離機能によりエンドポイントには影響が及ばないため、人的脅威を防ぐことも可能になります。

HP Sure Clickは、以下のように動作します。

- 高リスクのブラウジング、Word/Excel/PowerPointファイル・PDFはmicro‑VMで自動隔離。ハードウェア強制の分離でアプリごとに安全域を確保。

- タブ/ドキュメントを閉じるとmicro‑VMごと廃棄(持続化や横展開を阻止)。

- 要件はIntel VT(EPT)/AMD‑V(RVI)有効化。EDR/DLP併用で不正出力処理(OWASP LLM02)のリスクも封じる。

これにより、利用者の操作性を損なうことなく、万一の脅威を端末内で封じ込める強力な防御層を構築できます。なお、このHP Sure ClickはHPの法人向けPCにて限定的な機能が提供されており、HP Wolf Pro SecurityとHP Sure Click Enterpriseの導入によりフル機能が利用できるようになります。

参考:

日本HP HP Sure Click Enterprise 導入事例 - 株式会社エルテス

日本HP『脅威封じ込め技術によるエンドポイントセキュリティの強化』(資料番号: 4AA7-6963ENW)

日本HP『HP Sure Click Enterprise 製品データシート』(資料番号: 4AA7-7470ENUS)

日本HP『HP Sure Click Enterprise システム要件』

現場で使える「AIリスク最小化ロードマップ」:90日で実現する実践プロセス

本節では、生成AIを90日間で安全に導入する具体的な手順を解説します。最初の1ヶ月で現状把握とリスク評価、次の1ヶ月でルール作りと従業員教育、最後の1ヶ月で運用を定着させます。KPIや監査ログを活用してPDCAサイクルを回し、安全と効果を両立できる運用体制を構築した上で、全社展開へと進めます。

Day 1–30:現状把握とリスクアセスメント

最初の1ヶ月は、AI利用の現状把握とリスク評価に集中し、安全な導入に向けた土台を築きます。判断の遅れや見落としを防ぐには、まず社内での利用実態を正確に把握し、どこにどのようなリスクが潜んでいるかを可視化する必要があるためです。

具体的には、以下の項目を推進します。

- 体制構築: 推進委員会を設置し、責任の所在を明確化する。

- 実態調査: 全社的なAIの利用状況を棚卸し、シャドーITを把握する。

- リスク評価: 扱うデータを分類し、NIST AI RMFなどを参考にリスクを評価する。

- 暫定措置: 公開ツールへの機密情報入力を禁止するルールを即時徹底する。

これにより、取り組むべき課題の優先順位が明確になり、初動のリスクを抑えながら計画的に導入を開始できます。

Day 31–60:ポリシー策定と初期実装

次の1ヶ月では、具体的な社内ルールを策定し、それを支える技術的対策と従業員教育を並行して実装します。ルールだけでは現場での安全な運用は徹底できず、実際の業務プロセスに組み込む「技術」と、従業員の意識を高める「教育」を同時に進めることで、初めて実効性のある対策となるためです。

たとえば、ガイドラインや承認フローの確定、DLPや監査ログの導入、HP Sure Clickを含む製品群などによる端末保護、そして各部門の管理者や担当者向けの研修を実施します。

これにより、AI活用の「攻め」と情報漏洩対策の「守り」の両輪が回り始め、安全性を確保しながら効果測定を行う体制が整います。

Day 61–90:運用定着と評価・改善

最後の1ヶ月は、導入した仕組みを組織に定着させ、継続的に評価・改善する運用サイクルを確立します。一度ルールやシステムを導入しても、形骸化しては意味がありません。定期的な見直しを業務に組み込むことで、新たな脅威や利用方法の変化に対応し続けるためです。

具体的には、全社研修の実施に加え、月次の利用状況レビューやKPIモニタリング、四半期ごとのPDCAサイクルによるポリシーや技術の見直しなどを定常業務として組み込みます。

これにより、AI活用が持続的に改善される文化が醸成され、監査にも対応できる安全な運用基盤の上で、全社展開を加速できます。

費用対効果を可視化する:上司を説得するためのコストと成果の伝え方

AI導入の承認を得るための稟議の進め方を、実例と共に解説します。導入コストとKPI(工数削減など)を可視化してROIを算出。稟議テンプレートと想定問答集を用い、上司を納得させ、円滑なプロジェクト開始へと繋げます。

導入コストの内訳: ツール費用、研修費用、外部コンサル費用

AI導入の費用対効果を正確に評価するには、ツールの直接費だけでなく、教育や外部支援、さらには見落としがちな間接費まで含めた総所有コスト(TCO)を算出することが重要です。初年度は初期投資が大きくなりますが、2年目以降は運用費中心に圧縮できるため、複数年での計画が説得力を持ちます。

ツール・システム費用

AIを安全に運用する技術基盤には、ライセンス費用に加えて情報漏洩対策や端末保護のコストが不可欠です。これらは、AI利用における技術的な安全網を構築するための投資となります。

- 生成AI法人プラン:月額数千円~数万円/ユーザー

- セキュリティ対策:

○ エンドポイント保護(例:HP Wolf Pro Security):未知の脅威を端末内で隔離します。

目安:年間 約4,500円/端末○ DLP/監査ログ:機密情報の送信監視や利用状況の記録を行います。

目安:既存製品への追加で初期費用~100万円、新規導入で数百万円~

研修・教育費用

ツール導入の効果を最大化し、人的ミスを防ぐためには、全従業員への継続的な教育投資が欠かせません。ルールやシステムだけでは防げないリスクは、従業員のセキュリティ意識でカバーする必要があります。

- 外部研修・eラーニング:

○ 外部講師による研修: 1回あたり数十万~数百万円

○ eラーニング導入: 年間数十万~数百万円 - 間接コスト:

○ 従業員の研修受講時間や、運用ルールを浸透させるための教育時間も人件費として忘れずに計上します。

外部支援(コンサルティング・演習)費用

自社では気づきにくい専門的なリスクの特定や、対策の実効性を客観的に評価するために、外部専門家の活用が有効です。特にAI特有の脆弱性への対応は、高度な専門知識が求められます。

- リスクアセスメント支援: 数十万~数百万円

- ガイドライン策定支援: 数百万円~

- レッドチーム演習: 攻撃者視点でAIシステムの脆弱性を診断する実践的訓練です。

○ 目安:~150万円(OWASP LLM Top 10準拠)/年1回

測定すべき効果指標: 業務効率化(工数削減)、ブランド毀損リスクの低減、製品ページへの流入(CV)

AI導入の効果を評価するには、「業務効率化」「リスク低減」「売上貢献」という3つの側面から指標を設定し、定量的に測定することが不可欠です。これにより、投資対効果(ROI)を客観的に示し、継続的な改善活動へと繋げることができます。

業務効率化(工数削減)

AI導入効果として最も直接的に測定できるのが、業務工数の削減です。削減時間を金額に換算することで、投資対効果を客観的な数値で示すことが可能になります。

測定は、特定の業務におけるAI導入前後の作業時間を比較し、以下の式で算出します。

削減効果(円) = 削減時間 × 時間単価 × 実施回数

たとえば、報告書作成が30分から10分に短縮された場合(時間単価3,000円、月30件)、月額約3万円のコスト削減に相当します。

対象業務を複数組み合わせれば、年間で数百万円規模の効果を示すことも可能です。まずは対象業務を絞って測定を開始し、継続的に効果を可視化することが重要です。

ブランド毀損リスクの低減

情報漏洩や不適切な回答といった、AI利用に伴うブランドイメージの毀損リスクを、発生前にどれだけ低減できたかを金額換算して評価します。これは、潜在的な損害を回避する「守りの価値」を明確にし、セキュリティ投資の正当性を裏付けるためです。

評価は、「発生確率 × 想定損害額」という考え方で行います。

- 発生確率: 攻撃者視点で脆弱性を診断する「レッドチーム演習」などで評価します。

- 想定損害額: インシデント発生時の対応費用や賠償金などを試算します。

たとえば、年間2,000万円の損害が予測されるリスクを対策によってゼロにできれば、それがそのままリスク低減価値となります。

監査ログなどを通じてこの指標を継続的に改善していくことが求められます。

製品ページへの流入(CV)向上

AIが、Webサイトへの集客や最終的な成果(コンバージョン)にどれだけ貢献したかを測定します。これにより、AIがコスト削減だけでなく、売上向上という「攻めの投資」であることを証明できます。

測定は、UTMパラメータ(Web広告などの流入経路を識別する情報)を用いてAI経由のアクセスを特定し、コンバージョン率を掛けて成果を算出します。

- 具体例: AIチャットボット経由の製品ページアクセスが増加し、月に3件のコンバージョン(商談や資料請求など)が増えた場合。

このように、AIが生み出したアクセスが最終的に収益へどう繋がったかを定期的にレビューし、その因果関係を分析することが重要です。

【付録】 稟議用テンプレートと社内周知用Q&A

AI導入を円滑に進めるためには、意思決定を促す「稟議書」と、利用者の迷いをなくす「Q&A」という2つの文書が極めて重要です。これらを整備することで、経営層の迅速な承認と、現場での安全な利用定着を両立させることができます。

稟議書テンプレート(コピーして利用可)

AI導入の稟議を速やかに通すには、決裁者が知りたい「何を・いくらで・いつまでに・どれだけ効果があるか」という要点を1枚で示すテンプレートが有効です。これにより、判断に必要な情報が網羅され、迅速な意思決定を後押しできるためです。

テンプレートには、以下の項目を盛り込みます。最小構成でのスモールスタートを提案することが、承認への近道です。

<件名> 生成AIの安全活用による【対象部門・業務名】の効率化

提案概要: AIを適用する業務、範囲、そして適用しない条件を明記

背景・目的: 現状の課題と、AI導入で解決したい目的を記載

期待効果:

- 定量的効果: 削減時間 × 時間単価 × 実施回数 で算出した金額

- 定性的効果: 業務品質やセキュリティレベルの向上

主要評価指標(KPI): 工数削減率、誤答率、禁止事項の違反件数(目標0件)など

計画: 概念実証(PoC)から本番導入までの90日計画、教育、監査のスケジュール

体制: 責任者、承認者、運用窓口、インシデント発生時の連絡先

費用: 初期費用と月額運用費(ツール、セキュリティ対策、教育費用など)

リスクと対策: 情報漏洩にはDLP、誤情報には人による確認(HITL)などで対応

社内周知用Q&A(配布用)

従業員がAIを安全に利用するには、「迷ったらここを見る」という分かりやすいQ&Aを用意することが不可欠です。利用ルールや相談窓口を明確にすることで、従業員の不安を解消し、不用意なリスクの発生を未然に防ぎます。

このQ&Aは、eラーニング研修の完了と共に配布し、利用権限付与の条件とします。以下は配布するQ&Aの例です。

Q1. 使ってよいツールは?

A. 会社が承認した業務用アカウントのみです。個人アカウントでの利用は禁止です。

Q2. 入力してはいけない情報は?

A. 個人情報、お客様の情報、未公開の社内情報です。公開情報や匿名化したデータのみ入力できます。

Q3. AIの回答はそのまま使えますか?

A. 必ず人の目による事実確認(ファクトチェック)が必要です。

Q4. 問題が発生した場合は?

A. 1時間以内に指定の窓口へ報告してください。

Q5. 相談窓口はどこですか?

A. 情報システム部門のヘルプデスク(メール/Slack)です。

このようなQ&Aを入社時や異動時にも再周知することで、社内ルールの形骸化を防ぎ、安全なAI活用文化を定着させることができます。

おわりに

AIガバナンスは、AI活用の成果を最大化し、企業の信頼を守るための不可欠な土台です。なぜなら、ルール・技術・人による多層的な防御策を継続的に運用することが、生産性向上を確実な投資対効果(ROI)へと繋げ、EU AI法のような国際規制にも対応する唯一の方法だからです。

まずは単一の業務プロセスから小さく始め、効果をKPIで可視化しながら段階的に展開し、四半期ごとにレビューするサイクルを回すことが現実的な第一歩となります。本記事で示したロードマップを参考に今日から始めることで、90日後の安全で持続可能なAI活用を実現できます。

HPは、ビジネスに Windows 11 Pro をお勧めします。

Windows 11 は、AIを活用するための理想的なプラットフォームを提供し、作業の迅速化や創造性の向上をサポートします。ユーザーは、 Windows 11 のCopilotや様々な機能を活用することで、アプリケーションやドキュメントを横断してワークフローを効率化し、生産性を高めることができます。

組織において Windows 11 を導入することで、セキュリティが強化され、生産性とコラボレーションが向上し、より直感的でパーソナライズされた体験が可能になります。セキュリティインシデントの削減、ワークフローとコラボレーションの加速、セキュリティチームとITチームの生産性向上などが期待できる Windows 11 へのアップグレードは、長期的に経済的な選択です。旧 Windows OSをご利用の場合は、AIの力を活用しビジネスをさらに前進させるために、Windows 11 の導入をご検討ください。

※このコンテンツには日本HPの公式見解を示さないものが一部含まれます。また、日本HPのサポート範囲に含まれない内容や、日本HPが推奨する使い方ではないケースが含まれている可能性があります。また、コンテンツ中の固有名詞は、一般に各社の商標または登録商標ですが、必ずしも「™」や「®」といった商標表示が付記されていません。

ハイブリッドワークに最適化された、Windows 11 Pro+HP ビジネスPC

ハイブリッドなワークプレイス向けに設計された Windows 11 Pro は、さらに効率的、シームレス、安全に働くために必要なビジネス機能と管理機能があります。HPのビジネスPCに搭載しているHP独自機能は Windows 11 で強化された機能を補完し、利便性と生産性を高めます。

詳細はこちら