生成AIセキュリティ要点とオンデバイス活用

2025-12-23

ライター:倉光哲弘

編集:小澤健祐

なぜ生成AIのリスク対策が急務なのか? 企業向けの実践ガイド

生成AIの導入検討時、「入力した機密情報が漏えいしないか」「AIが誤った情報を出力しないか」といったリスクに不安を抱えていませんか。対策が曖昧なまま利用を開始すると、顧客情報の漏えいや誤情報によるブランドイメージの低下など、深刻な事態を招きかねません。

このようなリスクを回避する鍵は、クラウドAIとPC上で動作するオンデバイスAIの長所と短所を理解し、業務内容に応じて適切に使い分けることです。

本記事では、生成AIに潜むリスクの全体像から、社内説明でそのまま使える具体的な対策、コストを抑えながら安全に導入を始めるための実践的な手順までを網羅的に解説します。

まずは要点:生成AIリスク対策の3つの柱

生成AIのリスクは複雑に見えますが、対策の軸となる3つの柱で整理すれば、とるべき対策が明確になります。本章では「誰のリスクか」「どのような技術的危険があるか」「どう使い分けるべきか」という要点を解説し、迅速な意思決定と安全な導入計画の土台を築きます。

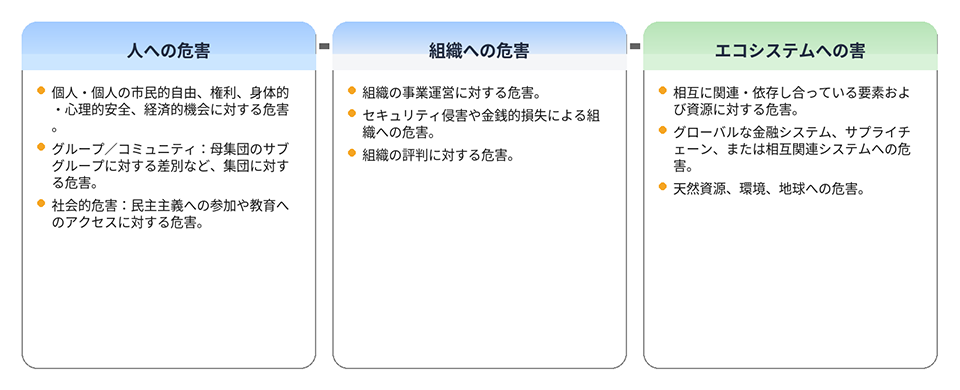

生成AIの「3者のリスク」を共通言語化する

生成AIのリスク対策を進める第一歩は、責任の所在を明確にすることです。誰がどのリスクを負うのかが曖昧なままでは、部署間で責任の押し付け合いが生じ、対策が前に進みません。

網羅的な管理の枠組みとして、NIST(ニスト:米国国立標準技術研究所)が提唱する「AI RMF(AIリスクマネジメントフレームワーク)」などが知られていますが、まずは社内での議論の出発点として、NRIセキュアなどが提唱する「利用者」「提供者」「社会」の3つの視点でリスクを分類する考え方が有効です。

- 利用者のリスク

従業員による機密情報の誤入力や、AIが生成した著作権侵害コンテンツの利用など、企業が主体的に管理すべきリスク。 - 提供者のリスク

AIサービス自体の脆弱性やデータ漏洩など、ベンダーの信頼性を見極めるべきリスク。 - 社会のリスク

誤情報の拡散やディープフェイクへの加担など、自社が社会に与える影響を配慮すべきリスク。

この分類方法を社内の「共通言語」とすることで、部門間の無用な対立を避け、利用ガイドラインの策定といった具体的な対策へスムーズに移行できます。

参考:

生成AIのリスクを整理する|3つの観点でリスクと対策を解説|ブログ|NRIセキュア

NIST『AI RMF 1.0 日本語版』

NIST AI Risk Management Framework(AIリスクマネジメントフレームワーク) – 概説 | デロイト トーマツ グループ

二大技術リスク:入力漏えいと出力不正確性

生成AIに特有の技術リスクは、大きく「入力時の情報漏えい」と「出力時の不正確さ」の2つに分けられます。

前者は従業員が機密情報をAIに送信してしまう危険性であり、後者はAIが事実に基づかない情報(ハルシネーション)や、著作権を侵害するコンテンツを生成する危険性を指します。

このように、ユーザーが情報を「入れる」時と、AIが情報を「出す」時の2つの場面に分けてリスクを整理することが、効果的な対策を検討する上での第一歩となります。

参考:

NTT DATA 『生成AI活用におけるセキュリティリスク対策の勘所』

使い分けの原則:クラウド、オンデバイス、ハイブリッド

生成AIの導入を「クラウド」か「オンデバイス」かの二者択一で考えるのは得策ではありません。セキュリティと利便性を両立するには、両方の長所を組み合わせた「ハイブリッド戦略」が不可欠です。

なぜなら、業務の用途や扱うデータの機密度によって、求められるセキュリティレベルや処理性能は異なるためです。それぞれの長所を理解し、以下のように使い分けることが重要です。

- クラウドAI

○ 長所: 常に最新かつ高性能なモデルが利用でき、複雑な分析も可能です。

○ 適した用途:市場調査やブログ記事の草案作成など、機密情報を含まない業務。 - オンデバイスAI

○ 長所:データが外部に送信されないため情報漏えいのリスクが極めて低く、オフラインでも利用できます。

○ 適した用途:議事録の要約や機密文書の翻訳など、プライバシー保護が最優先される業務。

このように、機密性の高い作業はPC内で完結させ、高度な分析はクラウドを利用するといった設計思想を持つことが、コストとリスクを最適化する鍵となります。

参考:

AWS 生成 AI ベストプラクティスフレームワーク v2 - AWS Audit Manager

オンデバイス AI とセキュリティ: 企業にとって本当に重要なこと - Windows Blog for Japan

生成AIリスクの全体像を俯瞰する

本章では、生成AIリスクの全体像をさらに深く掘り下げます。リスクを所有者別・技術別に体系的に分類することで、自社で起こりうる具体的な攻撃シナリオを想定しやすくなります。また、対策の要となるオンデバイスAIの基本も解説し、自社に最適なセキュリティ設計の土台を構築します。

リスクの分類:所有者別、技術別、そして典型シナリオ

生成AIへの脅威を網羅的に把握するためには、リスクを複数の視点から分類することが有効です。なぜなら、単純な情報漏えいだけでなく、AIを騙して操る攻撃や、学習データを汚染するなど、手口が多様化しているためです。

まず、前章で解説した「所有者」(利用者/提供者/社会)の視点で責任範囲を明確にした上で、国際的なセキュリティの知見である「技術的脆弱性」の視点を加えます。これには、生成AIの代表的な10の弱点をまとめた「OWASP LLM Top 10」や、AIへの攻撃手法を体系化した「MITRE ATLAS」などが参考となります。

これらの視点を組み合わせると、以下のような具体的なシナリオが想定できます。

- シナリオ例1:社内FAQボットが誤情報を回答し、顧客に損害を与える(提供者側の技術的リスク)

- シナリオ例2:従業員が営業支援ツールに個人の連絡先を入力してしまう(利用者側の運用リスク)

このようにリスクを整理することで、自社に必要な対策と責任分担を明確にしながら、検討を進められます。

参考:

OWASP/www-project-top-10-for-large-language-model-applications: OWASP Top 10 for Large Language Model Apps (Part of the GenAI Security Project) (OWASP Foundation)

MITRE ATLASとは何か?:第2回(偵察~AIモデルへのアクセス) | トレンドマイクロ (JP)

RAG(検索拡張生成)への攻撃手法|社内利用のLLMが社外から狙われる脅威|ブログ|NRIセキュア

事例で学ぶ:ハルシネーションの実害

ハルシネーションは単なる「AIの言い間違い」では済まされず、現実世界で深刻な損害を引き起こす可能性があります。ここでは、3つの領域における具体的な事例を紹介します。

- 【司法】存在しない判例を引用し、弁護士に制裁金

司法のような厳格さが求められる領域では、AIが生成した嘘が深刻な問題を引き起こします。弁護士には、提出する情報の正確性を担保する極めて重い責任があるためです。実際に2023年、米国ニューヨークの裁判において、弁護士がChatGPTの生成した存在しない判例を6件引用したとして、約75万円(5,000ドル)の制裁金を科される事態が起きました。この事例は、AIの出力を鵜呑みにせず、人の手による検証プロセスを組み込むことが、信用の失墜や法的なリスク回避に不可欠であることを示しています。 参考:Reuters - 【顧客接点】チャットボットの誤案内で、企業に賠償命令

顧客対応のチャットボットが出力する誤った回答は、直接的な賠償責任に発展する可能性があります。企業は、自社のウェブサイト上で提供する情報すべてに責任を負わなければならないからです。2024年、エア・カナダのチャットボットが顧客に誤った割引情報を案内した件について、カナダの裁判所は「AIであっても企業の代表である」と判断し、同社に補償を命じました。公開前のレビューと運用後の継続的な監査体制が、ブランドイメージの毀損や予期せぬ金銭的損失を防ぐ上で極めて重要です。 参考:American Bar Association - 【医療・専門分野】医学論文の引用、47%が捏造

医療など高度に専門的な分野では、「もっともらしく見える嘘の情報」が専門家の判断を誤らせ、危険な結果を招きかねません。AIが生成した説得力のある文章でも、その根拠が虚偽であれば、重大な意思決定を誤った方向へ導いてしまうからです。2023年に発表されたある医学系論文(Cureus誌)の調査では、AIが生成したコンテンツの引用元を検証したところ、正確なものはわずか7%で、47%は完全な捏造だったと報告されています。専門領域でAIを利用する際は、必ず専門家によるファクトチェックと引用元の検証を行うことが、重大な事故を防ぐための絶対条件となります。 参考:PubMed

これらの事例は、AIの誤った出力が単なる「間違い」ではなく、企業の信用失墜や金銭的損失に直結する経営リスクであることを明確に示しています。

オンデバイスAIとは何か

オンデバイスAIとは、PCやスマートフォンといったデバイスの内部でAIの処理を完結させる技術で、インターネットを介して外部サーバーとデータをやり取りするクラウドAIとは異なり、情報が端末の外に出ない点が最大の特徴です。これにより、情報漏えいのリスクを根本的に低減できます。

具体的には、機密情報を含む会議の議事録要約や、オフライン環境でのリアルタイム翻訳などに活用されます。近年、AI処理に特化した半導体「NPU(Neural Processing Unit)」の登場により、デバイス単体での高度な処理が現実的になりました。

これにより企業は、セキュリティが最優先される業務においても、AI活用の恩恵を安全に享受するという重要な選択肢を得られます。

出典:

エッジAI vs クラウドAI(IBM)

Arm Ethos-U85 NPU:小規模言語モデルによるエッジでの生成AIの実現(Arm Newsroom)

エッジインテリジェンスの強化:オンデバイスAIモデルに関する包括的調査(XUBIN WANG他、arXiv)

実践的ガイド:セキュリティ対策の「型」とPoC

本章では、具体的なセキュリティ対策の「型」と、それを実践するための導入手順を解説します。安全なデータの流れの設計方法から、用途に応じた判断基準、自社の成熟度診断、そして低コストで始める4週間の実証実験(PoC)計画まで、現場ですぐに使える知識が身につきます。

データフローと保護設計:推奨マトリクスで安全な設計を

生成AIを安全に設計する基本は、データの流れに沿って対策を講じることです。具体的には、「入力の制御」「モデルでの処理」「出力の監査」「監査証跡の記録」という一連の各段階で、情報が適切に扱われる仕組みを整えます。この流れに加え、PCやネットワークといった境界で暗号化やアクセス権限を徹底することで、情報漏えいや不正確な出力のリスクを最小限に抑えられます。

実際の使い分けは、扱うデータの機密性と求める応答速度を軸に判断するのが妥当です。たとえば:

- 社内文書の要約:機密性が最優先のため、オンデバイスAIが適しています。

- プログラムコードの生成:機密性と性能のバランスを取り、ハイブリッド形式で安全を確保します。

- 顧客向けFAQ:公開情報が中心で速度が重要なため、厳格な保護策を施したクラウドAIを利用します。

この判断基準を持つことで、どの業務にどのAI技術を使うべきかが明確になり、実用的な社内ガイドラインの策定に直結します。

参考:

上記は、ユースケースを類型化し管理策を適用する運用例です。根拠となるフレームワークは、AWSの「Generative AI Scoping Matrix」(管理策)とOWASP AI Exchangeの「リスク分析プロセス」(責任割当)です。自社の体制や規制要件に基づき調整してください。

AIセキュリティの概要(OWASP)

生成AIのセキュリティ保護:データ、コンプライアンス、プライバシーに関する考慮事項(AWS Security Blog)

運用成熟度:JNSAモデルで自社を診断

自社のセキュリティ対策がどの段階にあるかを客観的に診断するには、JNSA(日本ネットワークセキュリティ協会)が提供する「生成AIセキュリティ成熟度モデル」が有効です。このモデルは、AIの利用形態(外部サービスの利用、自社データ活用など)に応じて、必要な対策が体系的に整理されているため、自社が取り組むべき課題を特定しやすくなっています。

たとえば、社内データを活用する「RAG」という技術を導入する場合、モデルでは以下のような具体的な管理策が示されています。

- 参照できる情報源を、許可したものに限定する

- AIの出力内容を監査し、人手で確認する体制を整える

- 誤った回答が出力された際に、一時的に公開を停止する仕組みを設ける

この診断結果とJNSAが公開するチェックリストに基づき具体的な運用ルールを定めることで、自社の状況に合った継続的なセキュリティ改善が実現します。

参考:

生成AIを利用する上でのセキュリティ成熟度モデル | NPO日本ネットワークセキュリティ協会

4週間のスモールPoC:コストを抑えて再現性を高める

本格導入の前に、リスクを抑えつつ費用対効果を測るため、4週間程度の小規模なPoC(概念実証)から始めることを推奨します。まずは一つの業務に絞って試すことで、品質やコスト、応答速度といった具体的な数値を把握し、大規模な投資判断の前に課題を洗い出せます。

PoCの進め方の一例を以下に示します。

- Week1:用途の選定

対象業務の絞り込みと、扱うデータの機密性定義 - Week2:安全対策の実装

入力制御や出力確認といった、基本的な安全対策の設置 - Week-3:比較評価

クラウドとオンデバイス両環境における、品質・コスト・速度の比較 - Week4:評価と導入判断

PoC結果に基づく安全性の多角的な検証と、本格導入の可否判断

このように小さな成功体験を積み重ねることで、総保有コスト(TCO)を含めた現実的な導入計画の策定につながります。

深掘り:安全かつ現実的な導入

生成AI導入における現実的な答えは、クラウドとPC上のAI(オンデバイスAI)を組み合わせるハイブリッド戦略です。この手法は、多くの企業が懸念するセキュリティとコストの課題を同時に解決できる可能性があります。Microsoftが推奨するCopilot+ PCは、NPUというAI専用プロセッサが機密情報をPC内で安全に処理するよう設計されています。さらに、ハードウェアレベルのセキュリティ機能で端末自体を保護するため、専門家がいない環境でも安全な運用がしやすくなります。

たとえば、以下のように使い分けます。

- PCで完結(オンデバイス):社内報告書の要約など、機密性が高く反復的な業務。従量課金を避け、費用を固定化できます。

- クラウドと連携: 対外的なFAQ回答など、正確性が重要な業務。RAGという技術で出典を示し、AIの嘘(ハルシネーション)を防ぎます。

この設計により、AI利用の総コスト(TCO)が予測しやすくなり、短期間のPoC(概念実証)で安全性と投資対効果を確かめながら導入を進められます。

まとめ:安全な生成AI導入を成功させるロードマップ

本記事の要点を、明日から使える実践的なロードマップとしてまとめます。

生成AI導入を成功させる鍵は、クラウドとオンデバイスAIのハイブリッド活用です。これにより、情報漏えいや不正確な出力といった事業リスクを管理しながら、費用対効果を最大化できます。

具体的な導入計画は、以下の3ステップで進めることを推奨します。

ステップ1:現状の把握

JNSAの成熟度モデルを使い、自社の準備状況を客観的に評価します。

ステップ2:方式の選択

用途やデータの機密性に応じて、クラウドとオンデバイスを最適に使い分けます。

ステップ3:設計の検証

約4週間の短期PoC(概念実証)で、セキュリティと投資対効果を確かめます。

この手順を踏むことで、AI利用の総コスト(TCO)を予測し、根拠を持って社内ガイドラインを策定できます。ぜひ、安全なAI活用の第一歩を踏み出してください。

HPは、ビジネスに Windows 11 Pro をお勧めします。

Windows 11 は、AIを活用するための理想的なプラットフォームを提供し、作業の迅速化や創造性の向上をサポートします。ユーザーは、 Windows 11 のCopilotや様々な機能を活用することで、アプリケーションやドキュメントを横断してワークフローを効率化し、生産性を高めることができます。

組織において Windows 11 を導入することで、セキュリティが強化され、生産性とコラボレーションが向上し、より直感的でパーソナライズされた体験が可能になります。セキュリティインシデントの削減、ワークフローとコラボレーションの加速、セキュリティチームとITチームの生産性向上などが期待できる Windows 11 へのアップグレードは、長期的に経済的な選択です。旧 Windows OSをご利用の場合は、AIの力を活用しビジネスをさらに前進させるために、Windows 11 の導入をご検討ください。

※このコンテンツには日本HPの公式見解を示さないものが一部含まれます。また、日本HPのサポート範囲に含まれない内容や、日本HPが推奨する使い方ではないケースが含まれている可能性があります。また、コンテンツ中の固有名詞は、一般に各社の商標または登録商標ですが、必ずしも「™」や「®」といった商標表示が付記されていません。

ハイブリッドワークに最適化された、Windows 11 Pro+HP ビジネスPC

ハイブリッドなワークプレイス向けに設計された Windows 11 Pro は、さらに効率的、シームレス、安全に働くために必要なビジネス機能と管理機能があります。HPのビジネスPCに搭載しているHP独自機能は Windows 11 で強化された機能を補完し、利便性と生産性を高めます。

詳細はこちら