2024.03.28

生成AIをよりよく使える「AI PC」を使いこなして他社との競争に打ち勝て!

2022年の末にOpenAIがChatGPTをリリースして以降、生成AI(Generative AI)というキーワードを耳にしない日はないと言ってよいだろう。こうしたIT技術というのは、IT業界の中だけで話題になっていることが以前までの通例であったが、生成AIに関してはそうしたITのメディアだけでなく、一般のメディアでも毎日取り上げられるような一種の社会現象となっている。

そして今、生成AIの革命が、ビジネスパーソンにおける生産性を向上させる為の必須デバイス、モバイルPCを大きく変えようとしているのをご存知だろうか。そのキーワードとなるのが“AI PC”である。AI PCとは生成AIを、PC上でより効率的かつ安心に使えるための新しいPCの名称として使われている単語だ。

こうした生成AIのトレンドは、ビジネスパーソンが日常的に使っているMicrosoft 365のような生産性向上ツールにまで広がっており、AIを使いこなしていかなければ競合他社との競争に勝てない、そんな時代を迎えつつある。

※本記事はTECH+にて掲載されたものです。

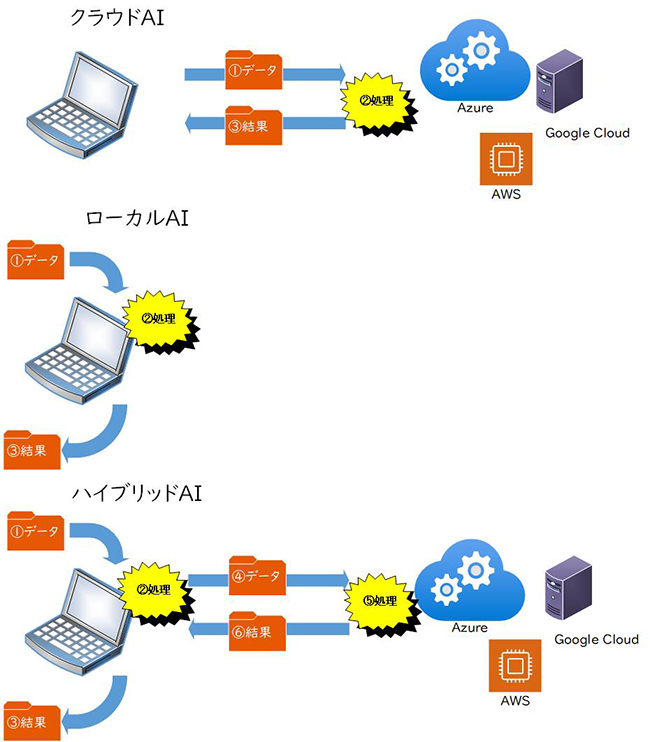

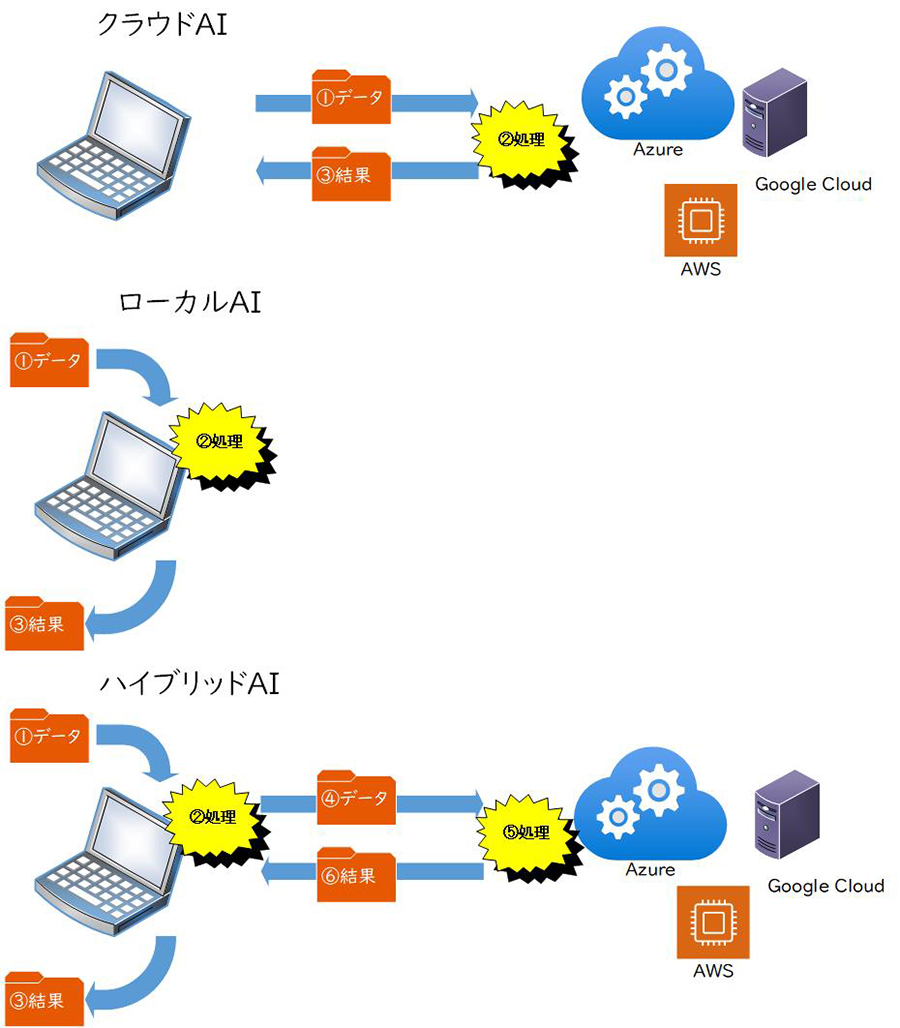

AIのアプリケーションを処理する演算器の位置がクラウドからローカル、そしてハイブリッドへと変わっていくというトレンド

AI PCはその名の通りAIアプリケーションが実行できるPCという意味だが、これまでとの大きな違いはAIアプリケーションをどこにある演算装置で処理するかにある。

クリックして拡大表示

上記の図は、AIの処理をどこにある演算装置(プロセッサー)で行なっているかを模式的に示したものだ。これまでのAIアプリケーションのほとんどが、クラウド、つまりインターネット上に置かれたデータセンターに格納されているCPUなどで処理される。そうした処理を行なうために、クライアントとなるPCは、データをクラウドにアップロードし、そのデータを元に処理が行なわれ、結果がクライアントに返される。

スマートフォン関連各社が提供している音声アシスタントなどがその典型例で、クライアントとなるスマートフォンに向かってユーザーがしゃべった音声データが、データセンターのサーバーにアップロードされ、サーバーのプロセッサーが音声認識を行ない、その結果をクライアントに返し表示する。

しかし、このようなフローを踏んでいる為、データを送ってから結果が返ってくるまでの遅延(レイテンシー)が発生し、ユーザーにとってはただ結果が帰ってくるのを待つしかない状況が発生するわけだ。また、データをクラウドにアップロードしなければならないため、セキュリティーの観点からクラウドストレージを使っていない企業にとっては、セキュリティー上の懸念があることも指摘しておきたい。

さらに、こうしたクラウドAIを提供する場合、アプリケーションを提供する企業はローカルのアプリケーションを管理するコストと同時に、クラウドにあるサーバーを利用するコストが発生する。このコストが固定費として発生することになるため、中小企業にとっては負担の増加になりかねないのもクラウドAIの弱点と言えるだろう。

これに対してAI PCでは、PC上にある何らかのプロセッサーを活用してAIの処理が行なわれる。これにより、ローカルのストレージに格納しているデータを直ちにプロセッサーが読み込んで処理を開始し、結果を返すことが可能になる。クラウドAIの場合には、その処理が終わるまでのネットワーク回線が遅かったりすると数秒程度かかる場合があるが、AI PCであればミリ秒単位で処理が完了し、ユーザーにとって快適なAIの活用が可能になる。

またローカルAIでは、ストレージ上のデータはPCの中だけで処理されるため、自社のデータがインターネットに出て行ったりすることがない。セキュリティー上の懸念からクラウドストレージを使用していない企業にとっても、AIが活用できる新しい機会を提供するのがローカルAIだということだ。

ただ、こうしたローカルAIが現実になったからといって、クラウドAIがなくなるかと言えば、そういう訳ではない。クラウドAIは、より大規模なAIの動作を可能としているため、クラウドAIでしかできないことも存在する。そのため、自社データがクローズなサーバーにまではアップロードされてよいという形での運用を行なっている企業であれば、ローカルAIとクラウドAIの良いところを活用する、ハイブリッドAIと呼ばれる使い方を検討するのが現実的だと言えるだろう。今後はこうしたハイブリッドAIがトレンドになっていくと考えられている。

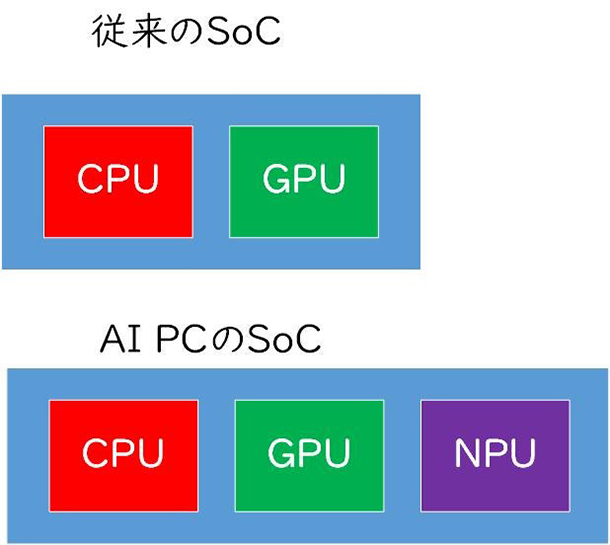

AI PCを特徴付けるのはSoCに内蔵されているNPU、AI処理を高性能・低消費電力で実行可能

AI PCのもう一つの大きな特徴は、NPU(Neural Processing Unit、エヌピーユーと発音する)と呼ばれる、新しい種類のプロセッサーが搭載され、それを利用してローカルAIの処理が行なわれることだ。

現代のノートPC、特にモバイル向けノートPCは、SoC(System on-a-Chip)と呼ばれる、一つのチップに複数のプロセッサーを内蔵している半導体により実現されている。昔のPCには、CPU(Central Processing Unit、中央演算装置)とGPU(Graphics Processing Unit)、そしてI/Oコントローラがそれぞれ別のチップとして基板上に実装されていたのだが、2010年代の前半に1チップに統合されSoC化された。CPUはソフトウエアの起動やデータの処理などを行ない、GPUはグラフィックスの処理や、大量のデータを並列に処理するなど、それぞれ異なる役割を担っている。

なお、ゲーミングPCなどではより強力な性能を持つGPUが、SoCから独立した形で別途搭載されている例がある。というのも、ゲーミングPCやワークステーションPCなどでは、グラフィックスや大量のデータ処理により高い性能を必要とするためで、そうしたPCでは今でもGPUが別で搭載されている。

そうしたCPU、GPUに加えて最新のSoCにはNPUという、AI処理に特化した専用のプロセッサーが統合されている。具体的にはAIの推論処理と呼ばれる、学習済みのAIモデルがネコはネコ、犬は犬と判別する処理を、CPUやGPUに比べて高い性能で、かつ低消費電力で行なえるというわけだ。このNPUが登場した背景には、AIの処理をローカルで行なうにあたり、既存のCPUやGPUよりも高性能かつ電力効率に優れたチップが必要となったことにあり、ここ1~2年でNPUの順次統合が進んでいった。

最初にNPUを統合したのは、Arm版Windows(Windows on Arm)向けにSoCを提供しているQualcommで、現行製品の“Snapdragon 8cx Gen 3 Compute Platform”にも搭載している。その他にも、2024年の中頃までに商用製品に搭載し出荷される予定となっている次世代製品“Snapdragon X Elite”には、より高性能なNPUを搭載していることを既に明らかにしている。また、Windowsプラットフォームで一般的に使われているx86プロセッサーを提供するAMDとIntelも昨年NPU内蔵製品を発表し、既に出荷を開始している。

また現在のPC業界では、そうしたNPUを活用するアプリケーションの開発にも取り組んでいる。SoCベンダーは、ローカルでAI処理を行なうアプリケーションの開発を促進する開発キットを、ISV(独立系ソフトウエアベンダー)に対して提供中だ。このため、既にCPU/GPUを利用したローカルでのAI処理を行なうアプリケーションの数は、数百もの数にのぼっている。その代表格となるのが、Adobeが提供するクリエイターツールのCreative Cloudであり、Premiere ProやPhotoshopなどのアプリケーションでは、すでにCPUやGPUを利用したローカルAIの機能を実装している。

今後はNPUへの対応が進んでいくことになると予想されるが、既にCPUやGPUを利用してAI推論を行うアプリケーションが、NPUに対応することは難しい話ではなく、時間が経つにつれその数は増えていくだろう。なお、Windows 11の標準機能であるビデオ会議のカメラエフェクト(背景ぼかしや自動フレーミング)機能であるWindows Studio Effectsは既にNPUに対応しており(というよりもNPUがないと機能が使えない)、CPUへの負荷が高いことが知られる背景ぼかしをCPUに負荷をかけずに利用可能だ。今後はそうしたアプリケーションがISVからも提供され実際に利用できるようになっていくと思われる。